Hardware de referencia: Laptop HP (16GB RAM + 16GB SWAP)

Repositorio oficial: https://github.com/ollama/ollama

Web Ollama: https://ollama.com/download

Este artículo documenta el proceso completo para desplegar un entorno de Inteligencia Artificial local, optimizando el almacenamiento y superando las restricciones de seguridad de Debian.

Durante décadas, la informática personal ha girado en torno a una idea central: el control del usuario sobre su máquina. Sin embargo, en los últimos años, ese principio ha sido erosionado por un modelo basado en la nube, la externalización del cómputo y la concentración del conocimiento en manos de grandes corporaciones.

La inteligencia artificial moderna nace, paradójicamente, como tecnología académica abierta, pero rápidamente es absorbida por modelos de negocio cerrados. Plataformas como ChatGPT, Gemini o Copilot ofrecen potencia a cambio de dependencia, y comodidad a cambio de soberanía.

La ejecución local de modelos de lenguaje supone, por tanto, un retorno a los principios clásicos de la informática: control, previsibilidad, propiedad y responsabilidad.

1. Introducción

La inteligencia artificial generativa ha dejado de ser un experimento de laboratorio para convertirse en una herramienta estratégica en entornos profesionales, educativos y empresariales. Sin embargo, el uso de servicios cerrados en la nube plantea interrogantes legítimos sobre privacidad, soberanía del dato, dependencia de terceros y costes recurrentes.

En este contexto, el ecosistema de IA privada, local y de código abierto cobra especial relevancia. Ejecutar modelos LLM (Large Language Models) en infraestructura propia —un simple PC o workstation GNU/Linux— es hoy una realidad técnica madura.

Esta guía constituye un manual técnico integral, orientado a administradores de sistemas, ingenieros, formadores y usuarios avanzados de GNU/Linux, con especial foco en Debian 13, donde se describe paso a paso cómo desplegar una solución completa de IA privada basada en:

- Ollama: motor de ejecución de modelos LLM en local.

- Open WebUI: interfaz web moderna, estilo ChatGPT, autoalojada mediante Docker.

El objetivo es proporcionar una referencia rigurosa, reproducible y mantenible, alineada con los principios del software libre, la documentación clásica y las buenas prácticas de administración de sistemas.

2. ¿Qué es Ollama?

Ollama es una plataforma de código abierto diseñada para descargar, gestionar y ejecutar modelos de lenguaje (LLM) en local, de forma sencilla y eficiente.

Desde el punto de vista técnico, Ollama actúa como:

- Un runtime optimizado para modelos LLM.

- Un gestor de modelos (descarga, versionado y eliminación).

- Un servicio local accesible por CLI y API HTTP.

Su filosofía recuerda a herramientas clásicas de Unix:

una sola cosa, bien hecha.

Ollama abstrae la complejidad del despliegue de modelos modernos (quantización, formatos, uso de CPU/GPU, memoria, etc.) y ofrece una experiencia coherente tanto para uso personal como profesional.

Es importante destacar que Ollama:

- No es un modelo: es el motor.

- No impone interfaz gráfica: se integra con terceros como Open WebUI.

- Respeta la privacidad: todo se ejecuta en local.

3. Características principales

Las características que han consolidado Ollama como estándar de facto en IA local son:

3.1 Simplicidad operativa

- Instalación mediante script oficial.

- CLI coherente y minimalista.

- Gestión automática de dependencias.

3.2 Amplio catálogo de modelos

Incluye soporte directo para:

- Llama 3/4

- Mistral / Mixtral

- Qwen

- Gemma

- Phi

- DeepSeek

- Modelos fine-tuned de la comunidad

3.3 Integración vía API

Ollama expone una API REST local (localhost:11434) que permite:

- Integración con aplicaciones propias.

- Uso desde IDEs.

- Conexión con interfaces web.

3.4 Optimización de recursos

- Quantización automática.

- Uso eficiente de CPU.

- Soporte opcional de GPU.

- Posibilidad de swap para escenarios controlados.

3.5 Software libre

- Código abierto.

- Comunidad activa.

- Transparencia técnica.

3.6 Requisitos previos

Antes de instalar, comprueba que tu sistema cumple con lo siguiente:

- Sistema operativo: Debian 12 o superior (amd64 o ARM64).

- CPU moderna con soporte AVX2 (recomendado para LLMs complejos).

- 8 GB de RAM mínimo (16+ recomendado para modelos grandes).

- Espacio de disco significativo (modelos pueden ocupar decenas de GB).

4. Instalación de Ollama en Debian 13

4.1 Requisitos previos

Sistema base recomendado:

- Debian 13 (estable)

- Arquitectura x86_64

- 16 GB de RAM (mínimo funcional)

- Swap 16 GB

- Usuario sin privilegios + sudo

4.2 Instalación oficial

Ollama proporciona un método de instalación directo y mantenible:

$ sudo apt install -y curl ca-certificates $ curl -fsSL https://ollama.com/install.sh | sh

Este script:

- Instala el binario en

/usr/bin/ollama. - Crea el usuario y servicio

ollama. - Configura systemd automáticamente.

Inicia, refresca y reinicia el servicio systemd en ollama:

$ sudo systemctl daemon-reload $ systemctl enable ollama $ sudo systemctl restart ollama

4.4 Verificación

$ ollama --version ollama version is 0.14.2

$ systemctl status ollama

● ollama.service - Ollama Service

Loaded: loaded (/etc/systemd/system/ollama.service; enabled; preset: enabled)

Drop-In: /etc/systemd/system/ollama.service.d

└─override.conf

Active: active (running) since Sun 2026-01-18 12:56:15 CET; 33min ago

Invocation: 311ee159fbef4d0dbcc1cd13015e7d62

Main PID: 2664 (ollama)

Tasks: 13 (limit: 18132)

Memory: 210.9M (peak: 504.1M)

CPU: 1.784s

CGroup: /system.slice/ollama.service

└─2664 /usr/local/bin/ollama serveSi el servicio está activo, Ollama está correctamente instalado.

5. Problema crítico: Ollama y la partición raíz /

Por defecto, Ollama guarda los modelos en la raíz del sistema, lo que en Debian es peligroso, ya que:

- Los modelos pesan entre 5 GB y 250 GB

- La raíz suele ser pequeña

- Puede provocar bloqueos del sistema

Solución profesional: mover los modelos a /home

5.1 Configuración avanzada de systemd para usar /home

5.1.1 Crear el directorio de modelos

$ mkdir -p /home/ojosdegato/ollama_models

Nota: Sustituye ojosdegato por tu usuario del sistema.

5.1.2 Permisos correctos

sudo chown -R ollama:ollama /home/ojosdegato/ollama_models sudo chmod +x /home/ojosdegato

Sin este paso, Ollama no arrancará en Debian.

6 Override del servicio systemd

Crear el archivo manualmente:

$ sudo nano /etc/systemd/system/ollama.service.d/override.conf

Contenido exacto:

[Service] Environment="OLLAMA_MODELS=/home/ojosdegato/ollama_models" Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*" ReadWritePaths=/home/ojosdegato/ollama_models

Nota: Sustituye ojosdegato por tu usuario del sistema y Aplicar cambios:

$ sudo systemctl daemon-reload $ sudo systemctl restart ollama

Verificación:

$ systemctl show ollama --property=Environment Environment=PATH=/usr/local/bin:/usr/bin:/bin:/usr/local/games:/usr/games OLLAMA_MODELS=/home/ojosdegato/ollama_models OLLAMA_HOST=0.0.0.0 "OLLAMA_ORIGINS=*"

6. Descargar y ejecutar un modelo LVM

Esta es la tabla oficial sobre los modelos a fecha de 01/2026:

| Modelo | Parámetros | Tamaño | Comando de descarga |

|---|---|---|---|

| Gemma 3 | 1B | 815 MB | ollama run gemma3:1b |

| Gemma 3 | 4B | 3.3 GB | ollama run gemma3 |

| Gemma 3 | 12B | 8.1 GB | ollama run gemma3:12b |

| Gemma 3 | 27B | 17 GB | ollama run gemma3:27b |

| QwQ | 32B | 20 GB | ollama run qwq |

| DeepSeek-R1 | 7B | 4.7 GB | ollama run deepseek-r1 |

| DeepSeek-R1 | 671B | 404 GB | ollama run deepseek-r1:671b |

| Llama 4 | 109B | 67 GB | ollama run llama4:scout |

| Llama 4 | 400B | 245 GB | ollama run llama4:maverick |

| Llama 3.3 | 70B | 43 GB | ollama run llama3.3 |

| Llama 3.2 | 3B | 2.0 GB | ollama run llama3.2 |

| Llama 3.2 | 1B | 1.3 GB | ollama run llama3.2:1b |

| Llama 3.2 Vision | 11B | 7.9 GB | ollama run llama3.2-vision |

| Llama 3.2 Vision | 90B | 55 GB | ollama run llama3.2-vision:90b |

| Llama 3.1 | 8B | 4.7 GB | ollama run llama3.1 |

| Llama 3.1 | 405B | 231 GB | ollama run llama3.1:405b |

| Phi 4 | 14B | 9.1 GB | ollama run phi4 |

| Phi 4 Mini | 3.8B | 2.5 GB | ollama run phi4-mini |

| Mistral | 7B | 4.1 GB | ollama run mistral |

| Moondream 2 | 1.4B | 829 MB | ollama run moondream |

| Neural Chat | 7B | 4.1 GB | ollama run neural-chat |

| Starling | 7B | 4.1 GB | ollama run starling-lm |

| Code Llama | 7B | 3.8 GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8 GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5 GB | ollama run llava |

| Granite-3.3 | 8B | 4.9 GB | ollama run granite3.3 |

Para nuestro ordenador laptor, 16 GB de RAM + 16 GB SSD de Swap = 32 GB, los modelos LLM que funcionan bien son los modelos que no superen las 16 GB de capacidad que es igual a la memoria del ordenador y se aconseja no tocar la swap, por ejemplo: yo he optado por Llama 3.1 de 8B y 4.7 GB, Una opción demasiado justa y no recomendable es Gemma 27B y 17GB, tocaria la Swap e iria muy lento.

Llama 3.1 es una colección de modelos de lenguaje de gran tamaño (LLM) desarrollada por Meta, lanzada originalmente a mediados de 2024 y consolidada como un estándar de código abierto en 2025 y 2026.

Sus características principales incluyen:

- El modelo 405B: Es el primer modelo de código abierto que compite directamente en capacidades con los modelos propietarios más avanzados como GPT-4o, siendo ideal para destilación de modelos, generación de datos sintéticos y tareas complejas de razonamiento.

- Capacidad Multilingüe: Soporta de forma nativa ocho idiomas, incluyendo español, inglés, alemán, francés, italiano, portugués, hindi y tailandés.

- Ventana de Contexto Ampliada: Ofrece una ventana de contexto de 128k tokens, lo que permite procesar documentos extensos o libros completos en una sola consulta.

- Variantes: Además del modelo 405B, incluye las versiones 8B (para dispositivos locales) y 70B (para aplicaciones empresariales de alto rendimiento).

Para descargar e instalar modelo LLM Llama 3.1 8B y 4,7 GB compatible con mi hardware:

$ ollama run llama3.1

Para ejecutar la IA en la terminal de debian ejecutamos el comando anterior: ollama run llama3.1

$ ollama run llama3.1 >>> ¿Quien es el ideologo de Linux? El creador de Linux es Linus Benedict Torvalds. Sin embargo, no es un ideólogo en el sentido tradicional del término, sino más bien un desarrollador y programador que creó la base del sistema operativo. Linux se basa en el modelo de desarrollo colaborativo (open-source) y tiene una comunidad activa y amplia que contribuye al código fuente y lo mejora continuamente. El proyecto Linux es un ejemplo clásico de software libre y abierto, y su filosofía está enfocada en la colaboración, la transparencia y la disponibilidad del código para cualquier persona. Linus Torvalds ha destacado por su enfoque hacia la comunidad y la colaboración, creando un entorno donde los desarrolladores pueden contribuir de manera activa al proyecto. Su visión ha permitido que Linux se convierta en uno de los sistemas operativos más utilizados en el mundo, especialmente en servidores y dispositivos de red. En cuanto a ideologías políticas o filosóficas relacionadas con Linux, hay varias corrientes dentro de la comunidad de desarrollo de software libre. Algunas de las principales incluyen: * El movimiento del software libre: se enfoca en el concepto de que los programas informáticos deben ser libres para que cualquier persona pueda estudiarlos, modificarlos y distribuirlos. * La filosofía de Richard Stallman: fundador de la Free Software Foundation (FSF), quien defiende la idea de que el software debe ser libre y está sujeto a las leyes de derechos de autor. >>> Send a message (/? for help)

Gestión y mantenimiento de modelos

$ ollama list # Listar modelos $ ollama rm modelo # Eliminar modelo $ df -h /home # Espacio disponible

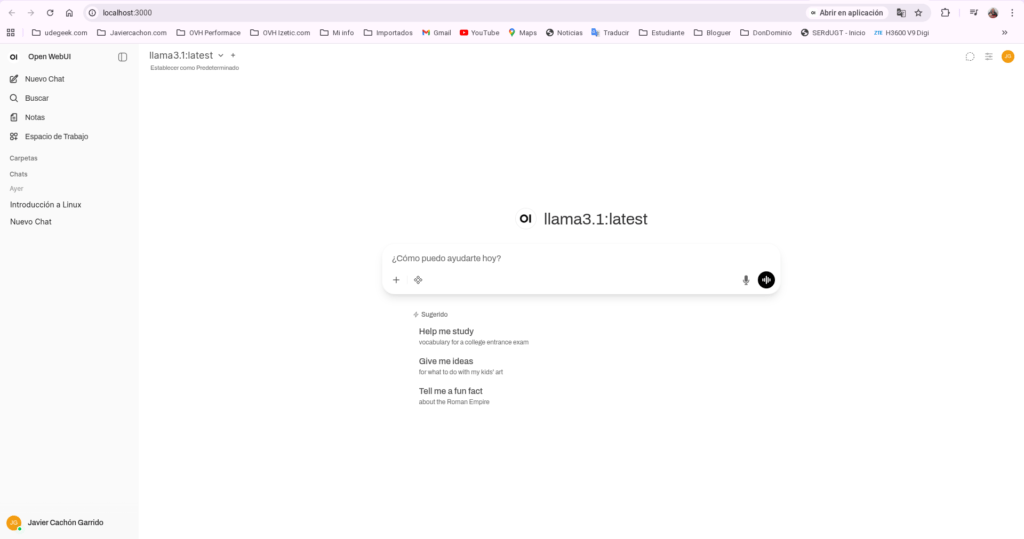

7. Instalación de Open WebUI con Docker (interfaz tipo ChatGPT)

7.1 Requisitos

$ sudo apt install docker.io docker-compose -y $ sudo systemctl enable --now docker $ sudo usermod -aG docker $USER $ newgrp docker

Nota: Sustituye $USER por tu usuario del sistema.

7.2 Despliegue de Open WebUI (puerto 3000)

docker run -d -p 3000:8080 \ --add-host=host.docker.internal:host-gateway \ -v open-webui:/app/backend/data \ -e OLLAMA_BASE_URL=http://host.docker.internal:11434 \ --name open-webui \ --restart always \ ghcr.io/open-webui/open-webui:main

7.3 Asegúrate de que el firewall permita el tráfico:

$ sudo ufw allow 11434/tcp.

Acceso web:

http://localhost:3000

Crea tu usuario y contraseña.

Resumen

Este artículo documenta de forma exhaustiva y basada en experiencia real la instalación, configuración y explotación de Ollama como motor de inteligencia artificial local en Debian 13, integrándolo con una interfaz gráfica tipo ChatGPT mediante Open WebUI y Docker. El objetivo principal es demostrar que la IA local, privada y soberana es viable en equipos domésticos si se aplican criterios técnicos correctos.

Descubre más desde javiercachon.com

Suscríbete y recibe las últimas entradas en tu correo electrónico.